Les observations destinées à la prévision du climat et à l’adaptation

Introduction

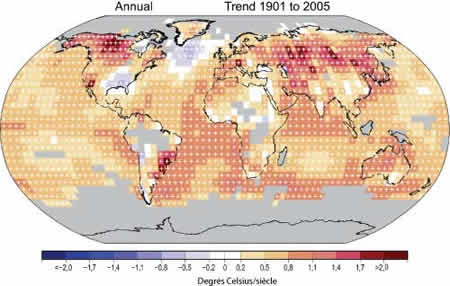

Le climat est en train de changer. Dans l’ensemble, les températures augmentent en raison de la modification de la composition de l’atmosphère due aux activités humaines (voir la figure 1), notamment la hausse de la concentration de dioxyde de carbone imputable aux combustibles fossiles (GIEC, 2007). La plupart des terres émergées se réchauffent plus vite que les océans. Si l’on examine attentivement la figure 1, on s’aperçoit toutefois que les températures ont en fait chuté dans le Sud-Est des États-Unis d’Amérique et dans l’Atlantique Nord entre 1901 et 2005. Comment expliquer un tel phénomène? Dans l’Atlantique Nord, la modification des courants océaniques y a certainement contribué. Dans le Sud-Est des États-Unis, les variations de la circulation atmosphérique, qui se sont soldées par un temps plus nuageux et beaucoup plus humide, ont joué un rôle déterminant (Trenberth et al., 2007). Ce genre de disparité illustre la difficulté de prévoir les changements climatiques, étant donné les immenses fluctuations spatiales et temporelles qui les caractérisent.

|

Figure 1 — Tendance linéaire des températures annuelles pour la période 1901-2005 (°C siècle –1). Les données détenues sur les zones grises sont insuffisantes pour produire des résultats fiables. Les tendances significatives (niveau 5 %) sont indiquées par des signes + en blanc. (Tiré de Trenberth et al., Bilan 2007 des changements climatiques: Les bases scientifiques physiques, Groupe d’experts intergouvernemental sur l’évolution du climat) |

Les recherches sur le climat et les projections des conditions futures se fondent sur des observations qui proviennent de sources nombreuses et variées mais qui visent souvent à prévoir le temps. La modification fréquente des instruments utilisés et des sites d’observation perturbe les relevés climatologiques, dont la continuité et l’homogénéité sont pourtant vitales pour évaluer correctement les variations et les modifications du climat. De plus en plus de données sont transmises par des plates-formes spatiales, mais les satellites ont une certaine durée de vie (cinq ans à peu près), leur orbite dérive et décline au fil du temps et leurs appareils se détériorent; les relevés peuvent donc être entachés d’erreurs patentes. Il est encore difficile aujourd’hui d’établir des archives climatologiques pouvant servir plusieurs fins à partir des observations.

La réduction du nombre de satellites d’observation de la Terre est également source de préoccupation, comme l’expose la récente étude décennale du National Research Council (2007). Les observations effectuées à partir du sol ne sont pas archivées correctement dans de nombreux pays. L’étalonnage des relevés climatologiques est primordial. Les changements climatiques se caractérisent par de légères fluctuations sur une période prolongée qui surviennent au sein de grandes variations associées à des phénomènes météorologiques et climatiques naturels, tel le phénomène El Niño. Le climat est déjà en train de changer et il est indispensable de suivre les manifestations et les causes de cette évolution au fur et à mesure qu’elles se produisent et de déterminer ce que réserve l’avenir—quand c’est possible. Nous devons créer un système fondé sur les observations afin de pouvoir indiquer aux décideurs ce qui arrive, les causes possibles et ce que l’on peut prévoir à différents horizons temporels.

Le présent article fait le point sur les activités qui sont conduites dans le but de transmettre aux décideurs des informations utiles aux mesures d’adaptation. Il a été préparé à partir de certaines discussions tenues lors d’un atelier sur les enseignements du quatrième Rapport d’évaluation du Groupe d’experts intergouvernemental sur l’évolution du climat (GIEC). La rencontre, qui a eu lieu à Sydney, Australie, du 4 au 6 octobre 2007, était parrainée par le Système mondial d’observation du climat (SMOC), le Programme mondial de recherche sur le climat (PMRC) et le Programme international géosphère-biosphère du Conseil international pour la science. Au sein du PMRC, le Groupe d’experts des observations et de l’assimilation des données (WOAP), présidé par l’auteur, s’efforce de mettre en relief les questions en suspens et de cerner la manière de les faire progresser.

Constituer une base de données pour l’adaptation

Un examen minutieux des signes vitaux de la planète a révélé que la Terre était en proie à une «fièvre» et que son état risquait de terriblement s’aggraver. «Le réchauffement du climat est sans équivoque» et il est «très probable» qu’il soit dû aux activités humaines. Telle est la conclusion du quatrième Rapport d’évaluation du GIEC (GIEC, 2007). Même s’il est primordial d’atténuer les changements climatiques d’origine anthropique, tout indique que le climat continuera d’évoluer de manière marquée au cours des prochaines décennies et que l’adaptation sera donc essentielle.

La première étape, essentielle, consiste à établir un système d’information sur le climat (Trenberth et al., 2002; 2006) qui renseigne les décideurs sur ce qui est en train de se passer, sur les raisons probables et sur les perspectives immédiates (voir la figure 2). Il faut, de manière générale, procéder à des observations (conformes aux exigences fixées pour l’étude du climat), mettre en place un système de suivi du fonctionnement, assimiler, archiver et conserver les données, assurer l’accès à ces données, y compris la gestion et l’intégration, analyser et réanalyser les observations et dériver des produits, notamment les relevés climatologiques (National Research Council, 2005), évaluer les phénomènes observés et leurs causes éventuelles (attribution), y compris les impacts probables sur les populations humaines et les écosystèmes, prévoir les changements climatiques à court terme (plusieurs décennies) et répondre aux attentes des décideurs et des utilisateurs.

|

Figure 2 — Schéma de la circulation des données dans un système d’information sur le climat. La recherche fondamentale alimente la recherche opérationnelle et appliquée qui appuie la mise au point de services climatologiques. Le système se fonde sur le système d’observation du climat, qui comprend l’examen et l’assimilation des données en vue de produire des analyses et des champs destinés à l’initialisation de modèles, et sur l’utilisation de modèles pour l’attribution et la prévision. Toutes les informations sont évaluées et intégrées dans des produits et des données diffusés aux utilisateurs, lesquels précisent leurs besoins et la façon d’améliorer l’information transmise. |

Pour cela, il faut tout d’abord rassembler les informations dont on dispose sur l’évolution du climat et les forçages externes puis, dans la mesure du possible, en établir l’origine. Toute activité d’attribution renvoie fondamentalement à la capacité de prévoir le climat, en particulier sa variabilité (phénomène El Niño/Oscillation australe—ENSO, variabilité saisonnière, etc.) et ses changements à long terme. De fait, il peut sembler indispensable de comprendre ce qui vient d’arriver et d’en déterminer les causes pour pouvoir passer à la prévision climatique suivante. L’objectif premier est de connaître les facteurs à l’origine des changements et de la variabilité observés, y compris les incertitudes présentes, afin de: a) améliorer le réalisme et l’efficacité des modèles et b) communiquer ces connaissances aux utilisateurs de l’information et au grand public.

L’attribution peut se faire en deux étapes: a) exécution de modèles atmosphériques afin d’établir dans quelle mesure les conditions récentes auraient pu être prévues, à partir de l’observation des températures de la mer en surface, de l’humidité du sol, de l’état des glaces de mer et d’autres facteurs inhabituels ayant un impact sur l’atmosphère; b) détermination des raisons pour lesquelles les températures de la mer en surface, l’humidité du sol, etc., sont ce qu’elles sont. L’affinement des modèles permet de connaître aujourd’hui l’origine de phénomènes qui restaient inexpliqués auparavant. Les modèles, qui sont encore loin d’être parfaits, risquent de sous-estimer les changements qu’il est possible d’imputer à une cause. Les chercheurs individuels peuvent devancer les résultats consensuels. Ces deux étapes doivent donc être réalisées en tenant compte des lacunes des modèles, sans négliger le caractère parfois très probant des données empiriques (statistiques, etc.). Il est nécessaire de disposer de moyens informatiques beaucoup plus larges pour effectuer des simulations d’ensemble et des simulations dont la résolution soit suffisante pour attribuer les causes de l’évolution du climat régional (par exemple, sécheresse, ouragans, crues). Un point important est de trouver une méthode efficace.

L’établissement de ce système d’information sur le climat correspond, dans un cadre plus opérationnel, à une grande partie des activités actuelles du GIEC. De nombreuses questions se posent sur la façon d’élaborer le système et sur les éléments qu’il devrait contenir pour être viable. Il faut ensuite améliorer et initialiser les modèles climatiques et effectuer des prévisions d’ensemble pour les 30 années à venir, comme cela est décrit ci-après.

Initialisation des modèles et validation des prévisions décennales

L’exécution de modèles atmosphériques avec certaines valeurs de la température de la mer en surface a souvent permis de comprendre les anomalies du climat passé. On a pu reproduire ainsi la sécheresse au Sahel (Giannini et al., 2003) et la formation du «Dust Bowl» (désert de poussière) aux Etats-Unis dans les années 30 (Schubert et al., 2004; Seager et al., 2005). Hurrell et al. (2004) ont montré que certains aspects de l’oscillation nord atlantique pouvaient être simulés en utilisant de telles valeurs. Il est essentiel de détenir les configurations de la température de la mer en surface à l’échelle du globe, simulées comme observées, mais il est tout à fait impossible d’effectuer des prévisions sans initialiser les informations sur les océans et d’autres composantes du système climatique. On ne saurait encore dire si cela accroît la prévisibilité, mais l’idée sous-jacente est que l’on pourrait mettre à profit toute la capacité de prévision dans le but d’améliorer la prise de décision en matière de planification et d’adaptation. Les premiers essais effectués selon cette approche (Smith et al., 2007) ont permis de dégager les éléments prometteurs et les avantages de l’initialisation des modèles mais, jusqu’à présent, ceux-ci concernent surtout le phénomène ENSO.

Les prévisions climatiques à échéance de 30 ans ne sont pas sensibles aux scénarios d’émissions, ce qui permet d’écarter presque totalement cet aspect, alors qu’elles seraient extrêmement précieuses. On a besoin de prévisions (des changements) climatiques sur cette période, accompagnées d’estimations de l’incertitude (ensembles) et de la sensibilité aux erreurs dans les conditions initiales. Cela permet aussi d’affiner les modèles en procédant à des vérifications régulières avec les données observées, comme on le verra plus loin. Le PMRC a amorcé la recherche dans ce domaine sous l’appellation «prévisions climatiques en continu», qui met en jeu des prévisions à diverses échéances, allant de la prévision numérique du temps sur plusieurs semaines (Expérience concernant la recherche sur les systèmes d’observation et la prévisibilité—THORPEX, http://www.wmo.int/pages/prog/arep/thorpex/) aux prévisions à l’échelle de plusieurs décennies, en passant par les prévisions de la variabilité interannuelle, y compris le phénomène ENSO. Toutes présentent des problèmes nécessitant la spécification de l’état initial observé.

La prévision du temps exige une analyse poussée de l’atmosphère, mais les incertitudes aux conditions initiales prennent de l’ampleur en quelques jours seulement. L’état initial de l’atmosphère est moins déterminant dans le cas des prévisions climatiques et l’on peut remplacer les valeurs d’une journée par celles d’une journée voisine. En revanche, les conditions d’autres composantes du système climatique, dont certaines ne sont pas vraiment primordiales pour la prévision météorologique courante, deviennent vitales. Ainsi, la température de la mer en surface, l’étendue des glaces de mer, le contenu calorifique de la couche supérieure de l’océan, l’humidité du sol, la couverture neigeuse et l’état de la végétation à la surface des terres émergées sont importants pour les prévisions portant sur une saison à une année. Les prévisions aux valeurs initiales sont déjà utilisables pour le phénomène El Niño et on s’apprête à étendre leur application aux océans du globe. Il est indispensable de disposer de plus d’informations sur les océans pour les échéances prolongées. La masse, l’étendue, l’épaisseur et l’état des glaces de mer et de la couverture neigeuse sont déterminants aux hautes latitudes. On doit connaître l’humidité du sol et l’état de la végétation en surface pour comprendre et prévoir les anomalies de précipitation et de température en saison chaude, ainsi que d’autres aspects de la surface terrestre. On a aussi besoin de données sur les changements systématiques de l’atmosphère (en particulier sa composition et les effets des éruptions volcaniques) et sur les forçages externes provoqués, par exemple, par les modifications du rayonnement solaire. Vu les incertitudes liées aux conditions initiales et la difficulté de prévoir en détail l’état de l’atmosphère et d’autres éléments du climat, il convient d’effectuer des ensembles de prévisions et d’établir des prévisions statistiques.

Cette opération, qui présente un intérêt direct pour les prévisions régionales, y compris la réduction d’échelle, devrait aboutir à des distributions de probabilité pour les champs visés. Les résultats auraient des applications concrètes à l’échelle régionale, là où les impacts sont les plus fortement ressentis et où les mesures d’adaptation peuvent être planifiées.

La capacité de prévision devrait découler de certains phénomènes qui évoluent lentement ou qui présentent une grande inertie thermique, par exemple les systèmes de courants océaniques, dont la circulation océanique profonde, les calottes glaciaires, le niveau de la mer et les propriétés des terres émergées. Une partie de cette capacité peut s’appuyer sur des expériences effectuées avec des modèles, mais uniquement dans la mesure où ceux-ci sont adéquats. La prise en considération des erreurs systématiques constitue un problème inhérent à l’assimilation des observations réelles. Il est primordial de détenir des jeux de données détaillés et de qualité pour initialiser les modèles et les vérifier par simulation rétrospective, ce qui renvoie à la réanalyse des composantes du système climatique, éventuellement selon un mode couplé. Ces données sont également essentielles pour parfaire les modèles. Un compromis doit être trouvé entre les notions de haute résolution et de fidélité, d’une part, et les avantages des exécutions multiples et des ensembles à perturbations, ainsi que des ensembles multimodèles, d’autre part. On doit encore faire des progrès au niveau des paramètres d’évaluation, mais une attention particulière doit être portée aux types de variabilité, tel le phénomène ENSO, et à la façon d’intégrer les éléments absents, comme les cyclones tropicaux.

Vérification des modèles au moyen des observations

Évaluer les modèles par rapport à diverses données d’observation permet d’interpréter les modifications passées du système climatique et d’établir la fiabilité des projections des changements futurs. Le quatrième Rapport d’évaluation du GIEC révèle que nous connaissons maintenant relativement bien les causes des variations de la température en surface observées au cours du XXe siècle à l’échelle du globe et des continents. Nous sommes en mesure de quantifier les apports des principaux facteurs externes (y compris les activités humaines) aux changements climatiques survenus pendant le siècle dernier. Notre capacité d’interpréter l’évolution de la plupart des autres variables en jeu (circulations, précipitations, valeurs extrêmes de divers types, etc.) demeure toutefois limitée.

Il est nécessaire de réaliser des expériences visant précisément à isoler et corriger les causes de biais persistants dus, par exemple, à la difficulté de représenter les processus de convection et, par conséquent, le cycle diurne des précipitations, les modes d’interaction couplés air-mer et la distribution de l’état des mers. On doit procéder à des tests ciblés avec des modèles climatiques en vue de faire apparaître les facteurs à l’origine des erreurs systématiques à l’échelle des processus. Par exemple, comme son nom l’indique, le Projet de comparaison de modèles de rétroactions liées aux nuages (CFMIP) (http://cfmip.metoffice.com/index.html) est axé sur les rétroactions propres aux nuages. Pour sa part, «Transpose» AMIP (Projet de comparaison des modèles de l’atmosphère) exploite des modèles climatiques en mode de prévision du temps pour examiner les biais qui apparaissent rapidement dans les prévisions à échéance de un à cinq jours.

Il faut élaborer sans tarder et appliquer dans l’ensemble de la communauté une série de paramètres reconnus pouvant servir à évaluer les nombreux modèles différents qui contribuent aux grands ensembles. Ces paramètres pourraient être fondés sur la capacité de simuler le cycle annuel moyen, la variabilité du climat observée sur quelques heures (diurnes) à plusieurs décennies et les caractéristiques de l’évolution historique du système climatique (estimée, par exemple, à partir de paléoarchives du dernier millénaire, du dernier maximum glaciaire ou d’autres époques lorsque les contraintes observationnelles le permettent), ainsi que sur la capacité de générer des prévisions du temps à court terme, en tant que problème de valeurs initiales, et de prévoir les différents aspects de l’évolution du système climatique à court terme pendant la période d’observation par satellite, en tant que problème de valeurs initiales et de forçage aux limites.

Retraitement et réanalyse

Alors que, globalement, le réseau de satellites d’observation de la Terre s’est amélioré de manière constante, en particulier pour ce qui est des mesures effectuées par les satellites d’exploitation, certaines difficultés ont surgi quant à l’établissement et au maintien d’un programme d’observation du climat à partir de l’espace, comme l’illustre la décision de réduire l’ampleur du Système national de satellites sur orbite polaire pour l’étude de l’environnement qui a gravement compromis les observations de ce type. De plus, les perspectives à long terme dans le domaine de l’observation de la Terre sont moins bonnes qu’elles ne l’ont déjà été (National Research Council, 2007).

Les problèmes récurrents que pose la mesure continue de variables climatiques cruciales à l’échelle de la planète soulignent la nécessité d’une concertation internationale entre les agences et les missions, en liaison avec les groupes d’utilisateurs du secteur du climat. La coordination est particulièrement importante lors de la conception des missions (afin d’assurer la cohérence et la continuité) et lors des processus d’étalonnage et de validation (afin de recueillir des données uniformes sur le plan spatial et temporel). Le Comité sur les satellites d’observation de la Terre a reconnu ces deux aspects par le biais du concept de constellation virtuelle et du Système mondial d’interétalonnage des instruments satellitaires.

On est loin de tirer pleinement parti des observations déjà réalisées. Un point clef de la stratégie visant à créer des relevés climatologiques est la nécessité de mettre sur pied un programme dynamique de retraitement des données passées (SMOC, 2005) et de réanalyse de toutes les données en champs mondiaux. Le quatrième Rapport d’évaluation du GIEC met en lumière les lacunes que présentent de nombreux relevés climatologiques, en particulier les observations spatiales. Des travaux ont toutefois montré que des améliorations étaient possibles grâce aux progrès accomplis dans la formulation des algorithmes et la résolution de certains problèmes, comme les écarts entre les données provenant de différents instruments et satellites, les effets des dérives d’orbite et toutes les questions liées à la création de relevés climatologiques exacts.

Le Groupe d’experts des observations et de l’assimilation des données relevant du PMRC a établi une série de lignes directrices concernant le moment et les circonstances où il convient de procéder à un retraitement (http://wcrp.ipsl.jussieu.fr/ReprocessingPrinciples.pdf). Il est grandement souhaitable que les principales agences spatiales s’entendent sur le choix des procédures d’étalonnage et des algorithmes. Les champs comprendraient la température, la vapeur d’eau, les nuages, le rayonnement, la température de la mer en surface, les glaces de mer, la couverture neigeuse et, surtout, les tempêtes tropicales et les ouragans. Le secteur de la recherche pourrait s’en charger, mais il faudrait disposer de ressources conséquentes et assurer la coordination voulue, en particulier, entre les agences spatiales internationales.

Les analyses de l’atmosphère globale sont réalisées en temps réel. Elles pourraient changer de nature selon les améliorations apportées au modèle d’assimilation utilisé pour étudier les observations. Une réanalyse consiste à retraiter toutes les observations correspondantes et d’autres encore à l’aide d’un système ultramoderne maintenu constant dans le temps, de manière à renforcer la continuité des relevés climatologiques produits. Le problème posé par les variations du système d’observation persistera encore. On disposera néanmoins d’une description plus cohérente de l’évolution de l’atmosphère, des océans, des terres émergées et d’autres composantes climatiques, y compris celles que l’on ne peut observer directement, laquelle aidera de nombreux clients à élaborer des produits climatologiques. La réanalyse concourt donc aux objectifs de renforcement des capacités poursuivis par des programmes tel le Système mondial des systèmes d’observation de la Terre et devrait constituer une partie essentielle de tout système d’observation du climat. Le Groupe d’experts des observations et de l’assimilation des données invite d’ailleurs à procéder à cette opération (http://wcrp.ipsl.jussieu.fr/SF_WOAPReanalysisClimate.html) et la Troisième Conférence internationale sur la réanalyse aura lieu à Tokyo, Japon, en janvier 2008.

Conclusion

Un système d’information sur le climat (voir la figure 2) pourrait intégrer les recherches et les données provenant du PMRC, du Programme international géosphère-biosphère, de DIVERSITAS (programme international de recherche scientifique sur la biodiversité (ESSP/PIGB/IHDP/PMRC)), du Programme international sur les dimensions humaines des changements de l’environnement planétaire (ESSP/DIVERSITAS/PIGB/PMRC) et du Système mondial d’observation du climat. La recherche fondamentale alimente la recherche opérationnelle et appliquée qui, à son tour, contribue à l’élaboration de produits et de services climatologiques.

Il convient de mener des recherches sur de nombreux aspects, dont le regroupement des observations, l’analyse et l’assimilation des données, les études d’attribution, les liens entre les variables qui ont des impacts physiques et environnementaux, l’exécution des modèles et la prise en compte de leurs biais, les prévisions et les projections, les réductions d’échelle et la régionalisation des résultats, le développement de systèmes d’information et les modalités d’interaction avec les usagers. Cela nécessitera des fonds importants mais pourrait permettre de constituer un système d’information très utile.

Références

Giannini, A., R. Saravanan et P. Chang, 2003: Oceanic forcing of Sahel rainfall on interannual to interdecadal time scales. Science, 302, 1027-1030.

Groupe d’experts intergouvernemental sur l’évolution du climat (GIEC), 2007: Bilan 2007 des changements climatiques —Les bases scientifiques physiques. Contribution du Groupe de travail I au quatrième Rapport d’évaluation du Groupe d’experts intergouvernemental sur l’évolution du climat (publié sous la direction de S. Solomon, D. Qin, M. Manning, Z. Chen, M.C. Marquis, K.B. Averyt, M. Tignor et H.L. Miller), Cambridge University Press, Cambridge, Royaume-Uni, et New York, N.Y., États-Unis, 996 p.

Hoerling, M. et A. Kumar, 2003: The perfect ocean for drought. Science, 299, 691-694.

Hurrell, J.W., M.P. Hoerling, A.S. Phillips et T. Xu, 2004: Twentieth Century North Atlantic climate change. Part I: Assessing determinism. Climate Dyn., 23, 371-389.

National Research Council, 2004 : Climate Data Records from Environmental Satellites: Interim Report, National Academy Press, Washington, D.C., états-Unis, 105 p.

National Research Council, 2007: Earth Science and Applications from Space: National Imperatives for the Next Decade and Beyond. The National Academies Press, Washington, D.C., États-Unis.

Schubert, S.D., M.J. Suarez, P.J. Region, R.D. Koster et J.T. Bacmeister, 2004: Causes of long-term drought in the United States Great Plains. J. Climate, 17, 485-503.

Seager, R., Y. Kushnir, C. Herweijer, N. Naik et J. Velez, 2005: Modeling of tropical forcing of persistent droughts and pluvials over western North America: 1856-2000. J. Climate, 18, 4065-4088.

Smith, D.M., S. Cusack, A.W. Colman, C.K. Folland, G.R. Harris et J.M. Murphy, 2007: Improved surface temperature prediction for the coming decade from a global climate model. Science, 317, 796-799.

Système mondial d’observation du climat, 2004: Implementation Plan for the Global Observing System for Climate in support of the UNFCCC. GCOS-92, 143 p.

Trenberth, K.E., T.R. Karl et T.W. Spence, 2002: The need for a systems approach to climate observations. Bull. Amer. Meteor. Soc., 83, 1593-1602.

Trenberth, K.E., B. Moore, T.R. Karl et C. Nobre, 2006: Monitoring and prediction of the Earth’s climate: A future perspective. J. Climate, 19, 5001-5008.

Trenberth, K.E., P.D. Jones, P. Ambenje, R. Bojariu, D. Easterling, A. Klein Tank, D. Parker, F. Rahimzadeh, J.A. Renwick, M. Rusticucci, B. Soden et P. Zhai, 2007: Observations: Surface and Atmospheric Climate Change. Dans: Bilan 2007 des changements climatiques — Les bases scientifiques physiques. Contribution du Groupe de travail I au quatrième Rapport d’évaluation du Groupe d’experts intergouvernemental sur l’évolution du climat (publié sous la direction de S. Solomon, D. Qin, M. Manning, Z. Chen, M.C. Marquis, K.B. Averyt, M. Tignor et H.L. Miller), Cambridge University Press, Cambridge, Royaume-Uni, et New York, N.Y., États-Unis, 235-336, plus annexe en ligne.

* National Center for Atmospheric Research, Boulder, CO 80307, États-Unis d'Amérique

Courriel: trenbert [at]ucar.edu